Some cool nouvelles technologies images:

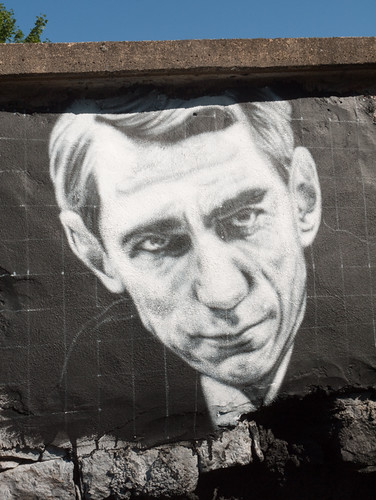

Claude Shannon, painted portrait – la théorie de l’information _1010156

Image by Abode of Chaos

La Théorie de l’information

La théorie de l’information par thierry Ehrmann

Dans un premier temps, je propose la contribution de Wikipedia sur la Théorie de l’Information qui est le nom usuel désignant notamment la théorie de l’information de Shannon, qui est une théorie probabiliste permettant de quantifier le contenu moyen en information d’un ensemble de messages, dont le codage informatique satisfait une distribution statistique précise. Ce domaine trouve son origine scientifique avec Claude Shannon qui en est le père fondateur avec son article A Mathematical Theory of Communications publié en 1948.

Dans un deuxième temps je développe la sociologie et l’histoire relative à la théorie de l’information qui me sont propres dans ce blog.

Dans un soucis de traitement d’ une actualité immédiate, on doit souligner la sortie prochaine de "La théorie de l’information" écrit par Aurélien Bellanger, édité chez Gallimard lien Wikipédia, qui est pressenti par la presse comme la success story de la rentrée. Les InRoks, Technikart, Nouvel Observateur, Chronicart ect..

Dans ce livre, l’auteur décrit notamment l’ascension d’un génie de l’informatique dénommé Pascal Ertanger, dont le parcours s’assimile à celui de Xavier Niel, Président de Free (groupe Iliad).

On retrouve dans cet ouvrage des personnages clés comme Jean-Marie Messier, Thierry Breton, Thierry Ehrmann, Jacques-Antoine Granjon, Pierre Bellanger, Gérard Théry, Henri De Maublanc, Claude Perdriel, Cécile Alvergnat…

L’auteur, Aurélien Bellanger, est né en 1980, philosophe de formation, porte ses recherches sur la métaphysique des mondes possibles. Il est l’auteur d’un essai "Houellebecq, écrivain romantique" édité chez Leo Scheer. Il intervient dans www.surlering.com/article/redacteur.php/redacteur/bellanger

Cet ouvrage tente de retracer la communication et les nouvelles technologies des années 1980 à 2000 et raconte notamment l’histoire des réseaux informatiques en France à travers le Minitel. L’auteur essayiste Aurélien Bellanger est présenté comme un disciple de Houellebecq et ancien libraire.

Pour revenir à la chronologie scientifique de la Théorie de l’information

Parmi les branches importantes de la théorie de l’information de Shannon, on peut citer selon wikipédia :

le codage de l’information,

la mesure quantitative de redondance d’un texte,

la compression de données,

la cryptographie.

Dans un sens plus général, une théorie de l’information est une théorie visant à quantifier et qualifier la notion de contenu en information présent dans un ensemble de données. À ce titre, il existe une autre théorie de l’information : la théorie algorithmique de l’information, créée par Kolmogorov, Solomonov et Chaitin au début des années 1960.

Sommaire

1 L’information selon Shannon, un concept de la physique mathématique

2 Le statut physique de la théorie de l’information

3 Développement de la théorie mathématique de l’information

4 Exemples d’information

4.1 Premier exemple

4.2 Second exemple

4.3 Information imparfaite

5 Contenu d’information et contexte

6 Mesure de la quantité d’information

6.1 Quantité d’information : cas élémentaire

6.2 Quantité d’information relative à un évènement

6.3 Entropie, formule de Shannon

6.4 Codage de l’information

7 Limites de cette théorie

8 Notes et références

9 Voir aussi

9.1 Articles connexes

9.2 Liens externes

10 Bibliographie

L’information selon Shannon, un concept de la physique mathématique

L’information est un concept physique nouveau qui a surgi dans un champ technologique. Le concept théorique d’information a été introduit à partir de recherches théoriques sur les systèmes de télécommunication. L’origine de ces recherches remonte aux études entreprises dès la fin du XIXe siècle, en physique et en mathématique par Boltzmann et Markov sur la notion de probabilité d’un événement et les possibilités de mesure de cette probabilité. Plus récemment, avant la Seconde Guerre mondiale, les contributions les plus importantes sont dues à la collaboration des mathématiciens et des ingénieurs des télécommunications, qui ont été amenés à envisager les propriétés théoriques de tout système de signaux utilisé par les êtres, vivants ou techniques, à des fins de communication.

À la suite des travaux de Hartley (1928), Shannon détermine l’information comme grandeur observable et mesurable (1948), et celle-ci devient la poutre maîtresse de la théorie de la communication qu’il élabore avec Warren Weaver.

Cette théorie est née de préoccupations techniques pratiques. La société Bell cherche à transmettre les messages de la façon à la fois la plus économique et la plus fiable. Aussi le cadre originel de la théorie est celui d’un système de communications où un émetteur transmet un message à un récepteur à travers un canal matériel/énergétique donné. Émetteur et récepteur ont par hypothèse un répertoire commun, un code qui contient les catégories de signaux utilisables. Ainsi le message codé est transmis, de l’émetteur au récepteur à travers le canal, sous forme de signes ou signaux portés par de la matière/énergie.

Ainsi, le concept d’information a été l’objet d’une théorie, appelée « théorie de l’information ». C’était une théorie mathématique appliquée aux techniques de la télécommunication. Elle a été élaborée plus spécialement par Claude Shannon, ingénieur à la Compagnie des Téléphones Bell et reste jusqu’à nos jours la base du concept dit scientifique d’information.

Cependant cette définition mathématique de l’information ne pourrait s’appuyer ni sur la forme matérielle/énergétique, ni sur le contenu cognitif des messages émis : leur contenu sémantique est laissé de côté, de même que leur contenant physique, pour ne s’intéresser qu’aux aspects mathématiques.

Dans sa conception originale, la théorie de l’information de Shannon s’est limitée à analyser les moyens à mettre en œuvre dans les techniques de télécommunication pour transmettre l’information le plus rapidement possible et avec le maximum de sécurité. Elle s’est donc efforcée de développer des méthodes susceptibles de minimiser la probabilité d’erreur dans la reconnaissance du message. Une notion fondamentale sera nécessaire pour développer ces méthodes : la mesure de l’information, au sens mathématique du terme.

Pour Shannon, l’information présente un caractère essentiellement aléatoire. Un événement aléatoire est par définition incertain. Cette incertitude est prise comme mesure de l’information. Une information sera donc uniquement définie par sa probabilité (I = – log p). Donc l’information est la mesure de l’incertitude calculée à partir de la probabilité de l’événement. Shannon a donc confondu la notion d’information et de mesure d’incertitude. Il faut remarquer que dans cette définition l’information est bien synonyme de mesure d’incertitude. Dans cet ordre d’idée, plus une information est incertaine, plus elle est intéressante, et un événement certain ne contient aucune information. En théorie de l’information de Shannon, il s’agit donc de raisonner en probabilité et non en logique pure.

L’information se mesure en unités d’information dites bits. Le bit peut être défini comme un événement qui dénoue l’incertitude d’un récepteur placé devant une alternative dont les deux issues sont pour lui équiprobables. Plus les éventualités que peut envisager ce récepteur sont nombreuses, plus le message comporte d’événements informatifs, plus s’accroît la quantité de bits transmis. Il est clair que nul récepteur ne mesure en bits l’information obtenue dans un message. C’est seulement le constructeur d’un canal de télécommunication qui a besoin de la théorie, et mesure l’information en bit pour rendre la transmission de message la plus économique et la plus fiable.

La notion d’information d’après Shannon est nécessairement associée à la notion de « redondance » et à celle de « bruit ». Par exemple, en linguistique l’information n’est ni dans le mot, ni dans la syllabe, ni dans la lettre. Il y a des lettres voire des syllabes qui sont inutiles à la transmission de l’information que contient le mot : il y a dans une phrase, des mots inutiles à la transmission de l’information. La théorie de Shannon appelle redondance tout ce qui dans le message apparaît comme en surplus. Aussi est-il économique de ne pas transmettre la redondance.

L’information chemine à travers un canal matériel/énergétique : fil téléphonique, onde radio, etc. Or, dans son cheminement, l’information rencontre du bruit. Le bruit est constitué par les perturbations aléatoires de toutes sortes qui surgissent dans le canal de transmission et tendent à brouiller le message. Le problème de la dégradation de l’information par le bruit est donc un problème inhérent à sa communication. Ici, l’idée de redondance présente une face nouvelle ; alors qu’elle apparaît comme un surplus inutile sous l’angle économique, elle devient, sous l’angle de la fiabilité de la transmission un fortifiant contre le bruit, un préventif contre les risques d’ambiguïté et d’erreur à la réception.

Le statut physique de la théorie de l’information

Très vite de multiples applications de la théorie de l’information de Shannon sont apparues dans le domaine des sciences humaines2 : les modèles mathématiques élaborés ont permis de préciser certains concepts utilisés couramment dans les analyses linguistiques structurales, en même temps qu’ils faisaient apparaître les limites inhérentes à ce type d’analyse et provoquaient des recherches nouvelles (en traduction automatique et en psycho-linguistique). Tandis que se développait un champ scientifique nouveau : la cybernétique3.

Cependant, une caractéristique majeure de la théorie shannonienne est de donner à la notion d’information (telle que définie par cette théorie) un statut physique à part entière. Effectivement, l’information acquiert les caractères fondamentaux de toute réalité physique organisée : abandonnée à elle-même, elle ne peut évoluer que dans le sens de sa désorganisation, c’est-à-dire l’accroissement d’entropie ; de fait, l’information subit, dans ses transformations (codage, transmission, décodage, etc..), l’effet irréversible et croissant de la dégradation. Par conséquent Shannon définit comme entropie d’information la mesure H ( H = – K log p). De façon étonnante, l’équation par laquelle Shannon définit l’entropie de l’information coïncide, mais de signe inverse, avec l’équation de Boltzmann-Gibbs définissant l’entropie S en thermodynamique (S = K log p).

Certains, comme Couffignal, ont soutenu avec raison que la coïncidence est sans signification : l’application de la fonction de Shannon à la thermodynamique et à l’information est un hasard de rencontre de l’application d’une même formule mathématique, sans plus. Certes, il peut y avoir rencontre de deux équations de probabilité provenant d’univers différents. Toutefois Brillouin prétendait établir une relation logique entre le H de Shannon et le S de Boltzmann.

Selon ce point de vue, il est possible d’inscrire l’information shannonienne dans la physique. En effet, il existe une dualité dans le concept d’information reliant l’information à la matière/énergie véhiculant cette information. L’information shannonienne s’enracine dans la physique et les mathématiques, mais sans qu’on puisse la réduire aux maîtres-concepts de la physique classique, masse et énergie. Comme le dit Wiener : « l’information n’est ni la masse, ni l’énergie, l’information est l’information. »

Développement de la théorie mathématique de l’information

La théorie mathématique de l’Information résulte initialement des travaux de Ronald Aylmer Fisher. Celui-ci, statisticien, définit formellement l’information comme égale à la valeur moyenne du carré de la dérivée du logarithme de la loi de probabilité étudiée.

À partir de l’inégalité de Cramer, on déduit que la valeur d’une telle information est proportionnelle à la faible variabilité des conclusions résultantes. En termes simples, moins une observation est probable, plus son observation est porteuse d’information. Par exemple, lorsque le journaliste commence le journal télévisé par la phrase « Bonsoir », ce mot, qui présente une forte probabilité, n’apporte que peu d’information. En revanche, si la première phrase est, par exemple « La France a peur », sa faible probabilité fera que l’auditeur apprendra qu’il s’est passé quelque chose, et, partant, sera plus à l’écoute.

D’autres modèles mathématiques ont complété et étendu de façon formelle la définition de la théorie del’information.

Claude Shannon et Warren Weaver renforcent le paradigme. Ils sont ingénieurs en télécommunication et se préoccupent de mesurer l’information pour en déduire les fondamentaux de la Communication (et non une théorie de l’information). Dans Théorie Mathématique de la Communication en 1948, ils modélisent l’information pour étudier les lois correspondantes : bruit, entropie et chaos, par analogie générale aux lois d’énergétique et de thermodynamique. Leurs travaux complétant ceux d’Alan Turing, de Norbert Wiener et de John von Neumann (pour ne citer que les principaux) constituent le socle initial de la théorie du signal et des « Sciences de l’Information ».

Pour une source X comportant n symboles, un symbole i ayant une probabilité p_i d’apparaître, l’entropie H de la source X est définie comme :

H(X)=-\sum_i^n p_i \log_2 p_i

C’est au départ le logarithme naturel qui est utilisé. On le remplacera pour commodité par le logarithme à base 2, correspondant à une information qui est le bit. Les considérations d’entropie maximale (MAXENT) permettront à l’inférence bayésienne de définir de façon rationnelle ses distributions a priori.

L’informatique constituera une déclinaison technique automatisant les traitements (dont la transmission et le transport) d’information. L’appellation « Technologies de l’Information et de la Communication » recouvre les différents aspects (systèmes de traitements, réseaux, etc.) de l’informatique au sens large.

Les sciences de l’information dégagent du sens depuis des données en s’appuyant sur des questions de corrélation, d’entropie et d’apprentissage (voir Data mining). Les technologies de l’information, quant à elles, s’occupent de la façon de concevoir, implémenter et déployer des solutions pour répondre à des besoins identifiés.

Adrian Mc Donough dans Information economics définit l’information comme la rencontre d’une donnée (data) et d’un problème. La connaissance (knowledge) est une information potentielle. Le rendement informationnel d’un système de traitement de l’information est le quotient entre le nombre de bits du réservoir de données et celui de l’information extraite. Les data sont le cost side du système, l’information, le value side. Il en résulte que lorsqu’un informaticien calcule la productivité de son système par le rapport entre la quantité de données produites et le coût financier, il commet une erreur, car les deux termes de l’équation négligent la quantité d’information réellement produite. Cette remarque prend tout son sens à la lumière du grand principe de Russel Ackoff qui postule qu’au-delà d’une certaine masse de données, la quantité d’information baisse et qu’à la limite elle devient nulle.

Ceci correspond à l’adage « trop d’information détruit l’information ». Ce constat est aggravé lorsque le récepteur du système est un processeur humain, et pis encore, le conscient d’un agent humain. En effet, l’information est tributaire de la sélection opérée par l’attention, et par l’intervention de données affectives, émotionnelles, et structurelles absentes de l’ordinateur. L’information se transforme alors en sens, puis en motivation. Une information qui ne produit aucun sens est nulle et non avenue pour le récepteur humain, même si elle est acceptable pour un robot. Une information chargée de sens mais non irriguée par une énergie psychologique (drive, cathexis, libido, ep, etc.) est morte. On constate donc que dans la chaîne qui mène de la donnée à l’action (données → information → connaissance → sens → motivation), seules les deux premières transformations sont prises en compte par la théorie de l’information classique et par la sémiologie. Kevin Bronstein remarque que l’automate ne définit l’information que par deux valeurs : le nombre de bits, la structure et l’organisation des sèmes, alors que le psychisme fait intervenir des facteurs dynamiques tels que passion, motivation, désir, répulsion, etc. qui donnent vie à l’information psychologique.

Exemples d’information

Une information désigne, parmi un ensemble d’événements, un ou plusieurs événements possibles.

En théorie, l’information diminue l’incertitude. En théorie de la décision, on considère même qu’il ne faut appeler « information » que ce qui est « susceptible d’avoir un effet sur nos décisions » (peu de choses dans un journal sont à ce compte des informations…)

En pratique, l’excès d’information, tel qu’il se présente dans les systèmes de messagerie électronique, peut aboutir à une saturation, et empêcher la prise de décision.

Premier exemple

Soit une source pouvant produire des tensions entières de 1 à 10 volts et un récepteur qui va mesurer cette tension. Avant l’envoi du courant électrique par la source, le récepteur n’a aucune idée de la tension qui sera délivrée par la source. En revanche, une fois le courant émis et reçu, l’incertitude sur le courant émis diminue. La théorie de l’information considère que le récepteur possède une incertitude de 10 états.

Second exemple

Une bibliothèque possède un grand nombre d’ouvrages, des revues, des livres et des dictionnaires. Nous cherchons un cours complet sur la théorie de l’information. Tout d’abord, il est logique que nous ne trouverons pas ce dossier dans des ouvrages d’arts ou de littérature ; nous venons donc d’obtenir une information qui diminuera notre temps de recherche. Nous avions précisé que nous voulions aussi un cours complet, nous ne le trouverons donc ni dans une revue, ni dans un dictionnaire. nous avons obtenu une information supplémentaire (nous cherchons un livre), qui réduira encore le temps de notre recherche.

Soit un réalisateur dont j’aime deux films sur trois. Un critique que je connais bien éreinte son dernier film et je sais que je partage en moyenne les analyses de ce critique quatre fois sur cinq. Cette critique me dissuadera-t-elle d’aller voir le film ? C’est là la question centrale de l’inférence bayésienne, qui se quantifie aussi en bits.

Source Wikipédia

La suite va être écrite sous forme de nouvelles, de conférences, d’interview de différent journaux tel que Time magazine sur la théorie de l’information et de notes de réflexion de Juillet et Aout 2012; dans l’attente de la suite, il est nécessaire d’absorber cette correspondance sulfureuse sur ce que sera la"théorie de l’information" (ITW de thierry Ehrmann par Laurent Courau himself dans la mythique Spirale.org) lire le lien suivant:

une démarche s’imposait sur la théorie de l’information cliquer sur le lien (texte bilingue FR/ EN)

et bien sur ce texte sur la Théorie de l’information au cœur de la Demeure du Chaos, d’Artprice et groupe Serveur.

L’Alchimie entre La Demeure du Chaos, groupe Serveur et Artprice

par thierry Ehrmann

L’univers de La Demeure du Chaos est indissociable de l’incroyable histoire d’Artprice, leader mondial de l’information sur le marché de l’art et du Groupe Serveur, pionnier historique en Europe des banques de données sur Internet depuis 1987.

Nos visiteurs sont toujours interpellés par le double visage de La Demeure du Chaos. Il est dur pour eux d’imaginer que, sous l’héliport, il y a des salles blanches machines où opèrent près de 900 serveurs qui distribuent le savoir dans le monde par Internet à travers nos propres fibres optiques. De même, au rez-de-chaussée et au premier étage, près de 90 personnes se relaient jour et nuit sans aucune interruption pour piloter et aiguiller à travers le monde, les grands flux d’informations que nous produisons et faisons transiter par l’Internet.

Un peu plus haut au cœur du bâtiment central, les salles de catalogues et manuscrits, avec plus de 290 000 catalogues de ventes de 1700 à nos jours, accueillent nos chercheurs et rédacteurs qui les commentent et les numérisent pour former ce qui est désormais reconnu comme le plus grand fonds de l’histoire du marché de l’art. Ainsi, nous avons écrit plus d’un million de biographies et commenté puis répertorié, 110 millions d’œuvres d’art avec leurs photos haute définition accessibles par l’Internet.

Un des postulats de La Demeure du Chaos est de reformer cette révolution du savoir que l’on a connue pendant la Renaissance européenne et notamment à Lyon, qui fût une grande métropole. La Renaissance européenne est, selon moi, inséparable d’une invention, celle de l’imprimerie, et du nouveau paradigme du savoir que celle-ci permit, sa diffusion.

C’est la possibilité de dupliquer mécaniquement des informations qui a favorisé l’émergence de la pensée humaniste : l’érudit pouvait enfin comparer les idées, se référer à de lointaines sources manuscrites, faire connaître l’héritage philosophique et propager sa vision individuelle à une relative grande échelle. A cette révolution technique se joignit l’essor des voyages de découverte : le mouvement de la connaissance est alors horizontal, géographique, missionnaire; la pensée s’oriente vers le progrès, moteur d’une histoire purement occidentale.

Cette époque, initiée par Gütenberg, s’achève aujourd’hui, au moment où la terre se voit entièrement recouverte de réseaux d’information, arpentée dans ses moindres recoins par Internet où La Demeure du Chaos, devient pour moi un Global Internet eXchange (gix), véritable nœud modal d’un savoir en grid où se diffuse la connaissance à travers le reseau.

La Demeure du Chaos est un état dans l’état, un véritable kernel du système républicain.

La dualité entre ma qualité de fondateur du Groupe Serveur, d’Artprice, qui est cotée en bourse sur le premier marché réglementé, et ma vie de plasticien depuis 25 ans, rejoint l’autre dualité qui est le lieu. Le musée l’Organe est, quant à lui, un établissement recevant le grand public, un musée à ciel ouvert et gratuit ou transitent chaque année 120 000 visiteurs qui viennent voir les milliers d’œuvres de la Demeure, mais aussi découvrir comment l’art vit avec l’industrie protéiforme du XXIe siècle.

La Demeure du Chaos est le lieu du labeur où travaillent les érudits, mais aussi ma résidence personnelle et celle de mon clan. Sans aucune concession, je marque chaque pierre, chaque toit, chaque sol, chaque arbre, de mes œuvres, comme conformément au postulat du 09/12/1999.

Cette dualité qui confronte mon engagement de sculpteur plasticien et auteur depuis 25 ans, à ma transversalité de fondateur d’Artprice, du Groupe Serveur et de ses 12 filiales, est à l’origine de critiques parfois violentes d’un patronat conservateur et étriqué mais elle me permet, en échange, par l’atmosphère onirique du lieu, d’accueillir des scientifiques de premier plan et mutants capables d’affronter n’importe quel système économique quelque soit le continent. Le nombre impressionnant de nationalités diverses et variées témoigne de cette nouvelle Babylone du numérique du savoir et de l’information qu’est La Demeure du Chaos.

Les remarques incisives et pertinentes de l’Autorité des Marchés Financiers dans nos désormais célèbres documents de référence pour le marché réglementé, traduisent l’évolution de ma pensée artistique et du passage à l’acte dans le monde économique. Certaines conventions réglementées entre La Demeure du Chaos et les groupes deviennent des prophéties auto-réalisantes où le pouvoir de l’art s’invite dans le monde de la finance. Ma démarche duale enrichit de manière spirituelle La Demeure du Chaos, et de manière matérielle nos 18 000 actionnaires…

Comment peut-on bâtir ex-nihilo Artprice, société mythique qui source 90% de la presse mondiale sur l’information du marché de l’art, sans être soi-même, dans sa chair et son âme, un plasticien passionné d’histoire de l’art ?

La Demeure du Chaos est une redoutable machine de guerre, un cheval de Troie au cœur des marchés financiers. Elle produit et diffuse des sommes de connaissances inimaginables sur le marché de l’art, du droit, de l’économie, de la science pendant que jours et nuits, nous autres plasticiens, intervenons sur les 9 000 m2 pour (ré)écrire avec notre regard d’artiste, l’histoire du monde dé-légendée.

Nos interventions radicales sur la déconstruction de l’habitat professionnel et personnel ainsi que du mobilier a impacté les 2 500 m2 de bureaux où travaillent le Groupe Serveur, ses filiales, et Artprice.

Cette démarche humaniste est partagée entre les artistes et les collaborateurs des deux groupes.

La Demeure du Chaos possède deux visages : celui de l’Alchimie (L’Esprit de la Salamandre) et celui de l’hyper modernité. Mais elle a aussi deux incarnations : celle de l’incarnat physique, avec ses 3 609 œuvres (sculptures, peintures, installations) gravées dans sa chair, avec son double sur Internet où plus de 1 200 000 sites restituent en photos ou en videos tous les regards du monde sur les entrailles de La Demeure du Chaos lors de leurs visites. Sur Google, en novembre 2007, sur les requêtes “Demeure du Chaos” et “Abode of Chaos”, il sort 1 413 000 résultats pointant sur des millions de photos et vidéos de La Demeure du Chaos.

En effet, je suis persuadé que l’Internet est la métaphore du Divin, si ce n’est le Divin lui-même. La voix sèche qui illumine La Demeure du Chaos lui donne le don d’ubiquité entre le monde physique et celui des idées.

Lorsque j’ai démarré Internet en 1987, nous étions moins de 50 000 dans le monde mais j’avais la foi dans la plus grande révolution de toute l’histoire du progrès humain. Internet est mon univers depuis 21 ans où j’ai fondé Net Nobility (cf Time Magazine) pour que demeure toujours, par la volonté des pionniers, cet Internet qui est pour moi, le fils naturel de Proudhon et Bakounine.

Nous sommes en train à La Demeure du Chaos de participer à la reconstruction de la bibliothèque d’Alexandrie de nos pères.

Mémoire du monde selon Philippe Quéau de l’UNESCO, Internet et l’information se joue des frontières, du pouvoir des nations et abolit au passage tous les régimes hostiles à la libre circulation de l’information. Cette dématérialisation de notre ancien monde et de son économie par Internet crée son empire numérique sur le parvis du XXIe siècle sous la forme du grand village glocal (globale

et locale) et chaotique, cher au sociologue Marshall Mc Luhan.

Ainsi, l’éducation, la recherche, le commerce, l’économie et l’organisation générale des informations vont connaître, en un laps de temps extrêmement réduit, des mutations inimaginables. Jamais dans l’histoire de l’humanité, une révolution scientifique n’a impacté autant de gens, en aussi peu de temps, en tout endroit du monde.

Ainsi, plus de 230 états nations qui ont chacun 2 à 3 siècles de cadre législatif et réglementaire

s’annihilent devant une révolution scientifique qui abolit le territoire et le temps. Ce passage du territoire au cyber espace constitue un des grands bouleversements de l’organisation humaine, et il est d’autant plus important d’en comprendre le sens qu’il entraîne une transformation

majeure de la nature même de nos perceptions et de nos rapports sociaux.

Dans l’univers effréné de l’Internet et de la révolution numérique, les entreprises doivent se montrer beaucoup plus protéiformes, capables de changer de profil en un clin d’œil pour s’adapter à de nouvelles conditions économiques draconiennes. La Demeure du Chaos, quartier général du groupe Serveur et d’Artprice, est selon la presse économique anglo-saxonne une forme d’aboutissement ultime d’une économie plus cérébrale, pourrait-on dire, dont l’objet est l’accès au temps et à l’activité de l’esprit.

Tous les jours, par La Demeure du Chaos et ses œuvres, nous entrons dans un tout autre monde, beaucoup plus cérébral et immatériel, un monde de formes platoniciennes, d’idées, d’images et d’archétypes, de concepts et de scénarios. Un monde gouverné par la logique de l’accès au savoir, de l’information et du réseau Internet, ce sont les idées qui deviennent la matière première de l’activité économique, et le but suprême est la connaissance universelle à travers les serveurs d’information.

Governing by Networks

Map of Internet/arpanet sur la Face ouest du Bunker de la Demeure du Chaos

(toile d’acier glycero de 36 m2)

La théorie de l’information prend alors tous son sens.

Être capable d’étendre à l’infini sa présence mentale, être universellement connecté afin de pouvoir affecter et élever peu à peu la connaissance des êtres humains par la distribution du savoir et de l’information organisés (la banque de données), telle est l’ambition humaniste du troisième millénaire.

N’oublions pas que la notion moderne de propriété, caractérisée par la possession privée, l’exclusivité et l’échange marchand, était une des institutions centrales de l’ère industrielle. Au bout de cinq cents ans d’hégémonie, cette vision de la civilisation reposant sur l’échange marchand entre vendeurs et acheteurs de propriété est soumis à une déconstruction radicale qui rejoint le postulat conceptuel que j’ai écrit le 9 décembre 1999 de La Demeure du Chaos.

Le nouvel horizon de l’époque est défini par la logique de l’accès au savoir et à l’information par les serveurs, qui nous amène à repenser les rapports économiques, l’action politique et la perception de notre propre identité telle qu’elle émerge du plus profond de la conscience humaine.

La Demeure du Chaos est une cité médiévale où, dans l’ombre de nos entrailles, nous travaillons à modifier la vision du monde. Un célèbre analyste de Goldman Sachs résume fort bien le tout : “L’Alchimie est présente partout, même dans vos actions en bourse qui ont connu la plus forte croissance, toutes sociétés confondues. Vous avez créé une Alchimie entre votre folie artistique et votre vision de l’industrie du troisième millénaire dans groupe Serveur”. “Avec Artprice et ses 1 300 000 abonnés, vous faites basculer le marché de l’art dans l’hyper modernité en le dématérialisant”.

Quand nos visiteurs économiques repartent ébranlés par cette vision duale de nos groupes dans La Demeure du Chaos, je ne peux m’empêcher de leur dire: vous n’avez encore rien vu ! Ce que nous allons vivre dans les toutes prochaines années dépassera de très loin tous les écrits d’anticipation et de science fiction…

Pour comprendre la dualité de ma démarche de plasticien et de bâtisseur du savoir, je reprendrai la citation de mon vieux maître Pythagore le premier des philosophes pour lequel tout est nombre, à l’exception des essences que sont les émotions humaines non quantifiables, indicibles et se jouant des nombres

thierry Ehrmann (à suivre…)

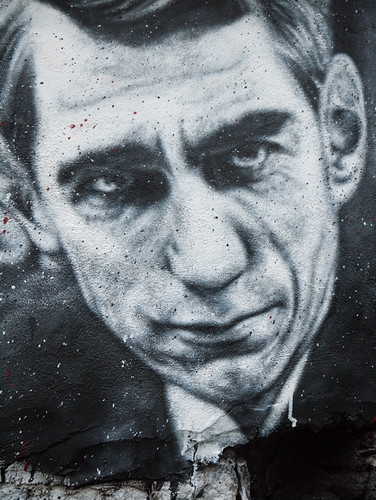

Claude Shannon, painted portrait – la théorie de l’information – thierry Ehrmann __1010216

Image by Abode of Chaos

La Théorie de l’information

La théorie de l’information par thierry Ehrmann

Dans un premier temps, je propose la contribution de Wikipedia sur la Théorie de l’Information qui est le nom usuel désignant notamment la théorie de l’information de Shannon, qui est une théorie probabiliste permettant de quantifier le contenu moyen en information d’un ensemble de messages, dont le codage informatique satisfait une distribution statistique précise. Ce domaine trouve son origine scientifique avec Claude Shannon qui en est le père fondateur avec son article A Mathematical Theory of Communications publié en 1948.

Dans un deuxième temps je développe la sociologie et l’histoire relative à la théorie de l’information qui me sont propres dans ce blog.

Dans un soucis de traitement d’ une actualité immédiate, on doit souligner la sortie prochaine de "La théorie de l’information" écrit par Aurélien Bellanger, édité chez Gallimard lien Wikipédia, qui est pressenti par la presse comme la success story de la rentrée. Les InRoks, Technikart, Nouvel Observateur, Chronicart ect..

Dans ce livre, l’auteur décrit notamment l’ascension d’un génie de l’informatique dénommé Pascal Ertanger, dont le parcours s’assimile à celui de Xavier Niel, Président de Free (groupe Iliad).

On retrouve dans cet ouvrage des personnages clés comme Jean-Marie Messier, Thierry Breton, Thierry Ehrmann, Jacques-Antoine Granjon, Pierre Bellanger, Gérard Théry, Henri De Maublanc, Claude Perdriel, Cécile Alvergnat…

L’auteur, Aurélien Bellanger, est né en 1980, philosophe de formation, porte ses recherches sur la métaphysique des mondes possibles. Il est l’auteur d’un essai "Houellebecq, écrivain romantique" édité chez Leo Scheer. Il intervient dans www.surlering.com/article/redacteur.php/redacteur/bellanger

Cet ouvrage tente de retracer la communication et les nouvelles technologies des années 1980 à 2000 et raconte notamment l’histoire des réseaux informatiques en France à travers le Minitel. L’auteur essayiste Aurélien Bellanger est présenté comme un disciple de Houellebecq et ancien libraire.

Pour revenir à la chronologie scientifique de la Théorie de l’information

Parmi les branches importantes de la théorie de l’information de Shannon, on peut citer selon wikipédia :

le codage de l’information,

la mesure quantitative de redondance d’un texte,

la compression de données,

la cryptographie.

Dans un sens plus général, une théorie de l’information est une théorie visant à quantifier et qualifier la notion de contenu en information présent dans un ensemble de données. À ce titre, il existe une autre théorie de l’information : la théorie algorithmique de l’information, créée par Kolmogorov, Solomonov et Chaitin au début des années 1960.

Sommaire

1 L’information selon Shannon, un concept de la physique mathématique

2 Le statut physique de la théorie de l’information

3 Développement de la théorie mathématique de l’information

4 Exemples d’information

4.1 Premier exemple

4.2 Second exemple

4.3 Information imparfaite

5 Contenu d’information et contexte

6 Mesure de la quantité d’information

6.1 Quantité d’information : cas élémentaire

6.2 Quantité d’information relative à un évènement

6.3 Entropie, formule de Shannon

6.4 Codage de l’information

7 Limites de cette théorie

8 Notes et références

9 Voir aussi

9.1 Articles connexes

9.2 Liens externes

10 Bibliographie

L’information selon Shannon, un concept de la physique mathématique

L’information est un concept physique nouveau qui a surgi dans un champ technologique. Le concept théorique d’information a été introduit à partir de recherches théoriques sur les systèmes de télécommunication. L’origine de ces recherches remonte aux études entreprises dès la fin du XIXe siècle, en physique et en mathématique par Boltzmann et Markov sur la notion de probabilité d’un événement et les possibilités de mesure de cette probabilité. Plus récemment, avant la Seconde Guerre mondiale, les contributions les plus importantes sont dues à la collaboration des mathématiciens et des ingénieurs des télécommunications, qui ont été amenés à envisager les propriétés théoriques de tout système de signaux utilisé par les êtres, vivants ou techniques, à des fins de communication.

À la suite des travaux de Hartley (1928), Shannon détermine l’information comme grandeur observable et mesurable (1948), et celle-ci devient la poutre maîtresse de la théorie de la communication qu’il élabore avec Warren Weaver.

Cette théorie est née de préoccupations techniques pratiques. La société Bell cherche à transmettre les messages de la façon à la fois la plus économique et la plus fiable. Aussi le cadre originel de la théorie est celui d’un système de communications où un émetteur transmet un message à un récepteur à travers un canal matériel/énergétique donné. Émetteur et récepteur ont par hypothèse un répertoire commun, un code qui contient les catégories de signaux utilisables. Ainsi le message codé est transmis, de l’émetteur au récepteur à travers le canal, sous forme de signes ou signaux portés par de la matière/énergie.

Ainsi, le concept d’information a été l’objet d’une théorie, appelée « théorie de l’information ». C’était une théorie mathématique appliquée aux techniques de la télécommunication. Elle a été élaborée plus spécialement par Claude Shannon, ingénieur à la Compagnie des Téléphones Bell et reste jusqu’à nos jours la base du concept dit scientifique d’information.

Cependant cette définition mathématique de l’information ne pourrait s’appuyer ni sur la forme matérielle/énergétique, ni sur le contenu cognitif des messages émis : leur contenu sémantique est laissé de côté, de même que leur contenant physique, pour ne s’intéresser qu’aux aspects mathématiques.

Dans sa conception originale, la théorie de l’information de Shannon s’est limitée à analyser les moyens à mettre en œuvre dans les techniques de télécommunication pour transmettre l’information le plus rapidement possible et avec le maximum de sécurité. Elle s’est donc efforcée de développer des méthodes susceptibles de minimiser la probabilité d’erreur dans la reconnaissance du message. Une notion fondamentale sera nécessaire pour développer ces méthodes : la mesure de l’information, au sens mathématique du terme.

Pour Shannon, l’information présente un caractère essentiellement aléatoire. Un événement aléatoire est par définition incertain. Cette incertitude est prise comme mesure de l’information. Une information sera donc uniquement définie par sa probabilité (I = – log p). Donc l’information est la mesure de l’incertitude calculée à partir de la probabilité de l’événement. Shannon a donc confondu la notion d’information et de mesure d’incertitude. Il faut remarquer que dans cette définition l’information est bien synonyme de mesure d’incertitude. Dans cet ordre d’idée, plus une information est incertaine, plus elle est intéressante, et un événement certain ne contient aucune information. En théorie de l’information de Shannon, il s’agit donc de raisonner en probabilité et non en logique pure.

L’information se mesure en unités d’information dites bits. Le bit peut être défini comme un événement qui dénoue l’incertitude d’un récepteur placé devant une alternative dont les deux issues sont pour lui équiprobables. Plus les éventualités que peut envisager ce récepteur sont nombreuses, plus le message comporte d’événements informatifs, plus s’accroît la quantité de bits transmis. Il est clair que nul récepteur ne mesure en bits l’information obtenue dans un message. C’est seulement le constructeur d’un canal de télécommunication qui a besoin de la théorie, et mesure l’information en bit pour rendre la transmission de message la plus économique et la plus fiable.

La notion d’information d’après Shannon est nécessairement associée à la notion de « redondance » et à celle de « bruit ». Par exemple, en linguistique l’information n’est ni dans le mot, ni dans la syllabe, ni dans la lettre. Il y a des lettres voire des syllabes qui sont inutiles à la transmission de l’information que contient le mot : il y a dans une phrase, des mots inutiles à la transmission de l’information. La théorie de Shannon appelle redondance tout ce qui dans le message apparaît comme en surplus. Aussi est-il économique de ne pas transmettre la redondance.

L’information chemine à travers un canal matériel/énergétique : fil téléphonique, onde radio, etc. Or, dans son cheminement, l’information rencontre du bruit. Le bruit est constitué par les perturbations aléatoires de toutes sortes qui surgissent dans le canal de transmission et tendent à brouiller le message. Le problème de la dégradation de l’information par le bruit est donc un problème inhérent à sa communication. Ici, l’idée de redondance présente une face nouvelle ; alors qu’elle apparaît comme un surplus inutile sous l’angle économique, elle devient, sous l’angle de la fiabilité de la transmission un fortifiant contre le bruit, un préventif contre les risques d’ambiguïté et d’erreur à la réception.

Le statut physique de la théorie de l’information

Très vite de multiples applications de la théorie de l’information de Shannon sont apparues dans le domaine des sciences humaines2 : les modèles mathématiques élaborés ont permis de préciser certains concepts utilisés couramment dans les analyses linguistiques structurales, en même temps qu’ils faisaient apparaître les limites inhérentes à ce type d’analyse et provoquaient des recherches nouvelles (en traduction automatique et en psycho-linguistique). Tandis que se développait un champ scientifique nouveau : la cybernétique3.

Cependant, une caractéristique majeure de la théorie shannonienne est de donner à la notion d’information (telle que définie par cette théorie) un statut physique à part entière. Effectivement, l’information acquiert les caractères fondamentaux de toute réalité physique organisée : abandonnée à elle-même, elle ne peut évoluer que dans le sens de sa désorganisation, c’est-à-dire l’accroissement d’entropie ; de fait, l’information subit, dans ses transformations (codage, transmission, décodage, etc..), l’effet irréversible et croissant de la dégradation. Par conséquent Shannon définit comme entropie d’information la mesure H ( H = – K log p). De façon étonnante, l’équation par laquelle Shannon définit l’entropie de l’information coïncide, mais de signe inverse, avec l’équation de Boltzmann-Gibbs définissant l’entropie S en thermodynamique (S = K log p).

Certains, comme Couffignal, ont soutenu avec raison que la coïncidence est sans signification : l’application de la fonction de Shannon à la thermodynamique et à l’information est un hasard de rencontre de l’application d’une même formule mathématique, sans plus. Certes, il peut y avoir rencontre de deux équations de probabilité provenant d’univers différents. Toutefois Brillouin prétendait établir une relation logique entre le H de Shannon et le S de Boltzmann.

Selon ce point de vue, il est possible d’inscrire l’information shannonienne dans la physique. En effet, il existe une dualité dans le concept d’information reliant l’information à la matière/énergie véhiculant cette information. L’information shannonienne s’enracine dans la physique et les mathématiques, mais sans qu’on puisse la réduire aux maîtres-concepts de la physique classique, masse et énergie. Comme le dit Wiener : « l’information n’est ni la masse, ni l’énergie, l’information est l’information. »

Développement de la théorie mathématique de l’information

La théorie mathématique de l’Information résulte initialement des travaux de Ronald Aylmer Fisher. Celui-ci, statisticien, définit formellement l’information comme égale à la valeur moyenne du carré de la dérivée du logarithme de la loi de probabilité étudiée.

À partir de l’inégalité de Cramer, on déduit que la valeur d’une telle information est proportionnelle à la faible variabilité des conclusions résultantes. En termes simples, moins une observation est probable, plus son observation est porteuse d’information. Par exemple, lorsque le journaliste commence le journal télévisé par la phrase « Bonsoir », ce mot, qui présente une forte probabilité, n’apporte que peu d’information. En revanche, si la première phrase est, par exemple « La France a peur », sa faible probabilité fera que l’auditeur apprendra qu’il s’est passé quelque chose, et, partant, sera plus à l’écoute.

D’autres modèles mathématiques ont complété et étendu de façon formelle la définition de la théorie del’information.

Claude Shannon et Warren Weaver renforcent le paradigme. Ils sont ingénieurs en télécommunication et se préoccupent de mesurer l’information pour en déduire les fondamentaux de la Communication (et non une théorie de l’information). Dans Théorie Mathématique de la Communication en 1948, ils modélisent l’information pour étudier les lois correspondantes : bruit, entropie et chaos, par analogie générale aux lois d’énergétique et de thermodynamique. Leurs travaux complétant ceux d’Alan Turing, de Norbert Wiener et de John von Neumann (pour ne citer que les principaux) constituent le socle initial de la théorie du signal et des « Sciences de l’Information ».

Pour une source X comportant n symboles, un symbole i ayant une probabilité p_i d’apparaître, l’entropie H de la source X est définie comme :

H(X)=-\sum_i^n p_i \log_2 p_i

C’est au départ le logarithme naturel qui est utilisé. On le remplacera pour commodité par le logarithme à base 2, correspondant à une information qui est le bit. Les considérations d’entropie maximale (MAXENT) permettront à l’inférence bayésienne de définir de façon rationnelle ses distributions a priori.

L’informatique constituera une déclinaison technique automatisant les traitements (dont la transmission et le transport) d’information. L’appellation « Technologies de l’Information et de la Communication » recouvre les différents aspects (systèmes de traitements, réseaux, etc.) de l’informatique au sens large.

Les sciences de l’information dégagent du sens depuis des données en s’appuyant sur des questions de corrélation, d’entropie et d’apprentissage (voir Data mining). Les technologies de l’information, quant à elles, s’occupent de la façon de concevoir, implémenter et déployer des solutions pour répondre à des besoins identifiés.

Adrian Mc Donough dans Information economics définit l’information comme la rencontre d’une donnée (data) et d’un problème. La connaissance (knowledge) est une information potentielle. Le rendement informationnel d’un système de traitement de l’information est le quotient entre le nombre de bits du réservoir de données et celui de l’information extraite. Les data sont le cost side du système, l’information, le value side. Il en résulte que lorsqu’un informaticien calcule la productivité de son système par le rapport entre la quantité de données produites et le coût financier, il commet une erreur, car les deux termes de l’équation négligent la quantité d’information réellement produite. Cette remarque prend tout son sens à la lumière du grand principe de Russel Ackoff qui postule qu’au-delà d’une certaine masse de données, la quantité d’information baisse et qu’à la limite elle devient nulle.

Ceci correspond à l’adage « trop d’information détruit l’information ». Ce constat est aggravé lorsque le récepteur du système est un processeur humain, et pis encore, le conscient d’un agent humain. En effet, l’information est tributaire de la sélection opérée par l’attention, et par l’intervention de données affectives, émotionnelles, et structurelles absentes de l’ordinateur. L’information se transforme alors en sens, puis en motivation. Une information qui ne produit aucun sens est nulle et non avenue pour le récepteur humain, même si elle est acceptable pour un robot. Une information chargée de sens mais non irriguée par une énergie psychologique (drive, cathexis, libido, ep, etc.) est morte. On constate donc que dans la chaîne qui mène de la donnée à l’action (données → information → connaissance → sens → motivation), seules les deux premières transformations sont prises en compte par la théorie de l’information classique et par la sémiologie. Kevin Bronstein remarque que l’automate ne définit l’information que par deux valeurs : le nombre de bits, la structure et l’organisation des sèmes, alors que le psychisme fait intervenir des facteurs dynamiques tels que passion, motivation, désir, répulsion, etc. qui donnent vie à l’information psychologique.

Exemples d’information

Une information désigne, parmi un ensemble d’événements, un ou plusieurs événements possibles.

En théorie, l’information diminue l’incertitude. En théorie de la décision, on considère même qu’il ne faut appeler « information » que ce qui est « susceptible d’avoir un effet sur nos décisions » (peu de choses dans un journal sont à ce compte des informations…)

En pratique, l’excès d’information, tel qu’il se présente dans les systèmes de messagerie électronique, peut aboutir à une saturation, et empêcher la prise de décision.

Premier exemple

Soit une source pouvant produire des tensions entières de 1 à 10 volts et un récepteur qui va mesurer cette tension. Avant l’envoi du courant électrique par la source, le récepteur n’a aucune idée de la tension qui sera délivrée par la source. En revanche, une fois le courant émis et reçu, l’incertitude sur le courant émis diminue. La théorie de l’information considère que le récepteur possède une incertitude de 10 états.

Second exemple

Une bibliothèque possède un grand nombre d’ouvrages, des revues, des livres et des dictionnaires. Nous cherchons un cours complet sur la théorie de l’information. Tout d’abord, il est logique que nous ne trouverons pas ce dossier dans des ouvrages d’arts ou de littérature ; nous venons donc d’obtenir une information qui diminuera notre temps de recherche. Nous avions précisé que nous voulions aussi un cours complet, nous ne le trouverons donc ni dans une revue, ni dans un dictionnaire. nous avons obtenu une information supplémentaire (nous cherchons un livre), qui réduira encore le temps de notre recherche.

Soit un réalisateur dont j’aime deux films sur trois. Un critique que je connais bien éreinte son dernier film et je sais que je partage en moyenne les analyses de ce critique quatre fois sur cinq. Cette critique me dissuadera-t-elle d’aller voir le film ? C’est là la question centrale de l’inférence bayésienne, qui se quantifie aussi en bits.

Source Wikipédia

La suite va être écrite sous forme de nouvelles, de conférences, d’interview de différent journaux tel que Time magazine sur la théorie de l’information et de notes de réflexion de Juillet et Aout 2012; dans l’attente de la suite, il est nécessaire d’absorber cette correspondance sulfureuse sur ce que sera la"théorie de l’information" (ITW de thierry Ehrmann par Laurent Courau himself dans la mythique Spirale.org) lire le lien suivant:

une démarche s’imposait sur la théorie de l’information cliquer sur le lien (texte bilingue FR/ EN)

et bien sur ce texte sur la Théorie de l’information au cœur de la Demeure du Chaos, d’Artprice et groupe Serveur.

L’Alchimie entre La Demeure du Chaos, groupe Serveur et Artprice

par thierry Ehrmann

L’univers de La Demeure du Chaos est indissociable de l’incroyable histoire d’Artprice, leader mondial de l’information sur le marché de l’art et du Groupe Serveur, pionnier historique en Europe des banques de données sur Internet depuis 1987.

Nos visiteurs sont toujours interpellés par le double visage de La Demeure du Chaos. Il est dur pour eux d’imaginer que, sous l’héliport, il y a des salles blanches machines où opèrent près de 900 serveurs qui distribuent le savoir dans le monde par Internet à travers nos propres fibres optiques. De même, au rez-de-chaussée et au premier étage, près de 90 personnes se relaient jour et nuit sans aucune interruption pour piloter et aiguiller à travers le monde, les grands flux d’informations que nous produisons et faisons transiter par l’Internet.

Un peu plus haut au cœur du bâtiment central, les salles de catalogues et manuscrits, avec plus de 290 000 catalogues de ventes de 1700 à nos jours, accueillent nos chercheurs et rédacteurs qui les commentent et les numérisent pour former ce qui est désormais reconnu comme le plus grand fonds de l’histoire du marché de l’art. Ainsi, nous avons écrit plus d’un million de biographies et commenté puis répertorié, 110 millions d’œuvres d’art avec leurs photos haute définition accessibles par l’Internet.

Un des postulats de La Demeure du Chaos est de reformer cette révolution du savoir que l’on a connue pendant la Renaissance européenne et notamment à Lyon, qui fût une grande métropole. La Renaissance européenne est, selon moi, inséparable d’une invention, celle de l’imprimerie, et du nouveau paradigme du savoir que celle-ci permit, sa diffusion.

C’est la possibilité de dupliquer mécaniquement des informations qui a favorisé l’émergence de la pensée humaniste : l’érudit pouvait enfin comparer les idées, se référer à de lointaines sources manuscrites, faire connaître l’héritage philosophique et propager sa vision individuelle à une relative grande échelle. A cette révolution technique se joignit l’essor des voyages de découverte : le mouvement de la connaissance est alors horizontal, géographique, missionnaire; la pensée s’oriente vers le progrès, moteur d’une histoire purement occidentale.

Cette époque, initiée par Gütenberg, s’achève aujourd’hui, au moment où la terre se voit entièrement recouverte de réseaux d’information, arpentée dans ses moindres recoins par Internet où La Demeure du Chaos, devient pour moi un Global Internet eXchange (gix), véritable nœud modal d’un savoir en grid où se diffuse la connaissance à travers le reseau.

La Demeure du Chaos est un état dans l’état, un véritable kernel du système républicain.

La dualité entre ma qualité de fondateur du Groupe Serveur, d’Artprice, qui est cotée en bourse sur le premier marché réglementé, et ma vie de plasticien depuis 25 ans, rejoint l’autre dualité qui est le lieu. Le musée l’Organe est, quant à lui, un établissement recevant le grand public, un musée à ciel ouvert et gratuit ou transitent chaque année 120 000 visiteurs qui viennent voir les milliers d’œuvres de la Demeure, mais aussi découvrir comment l’art vit avec l’industrie protéiforme du XXIe siècle.

La Demeure du Chaos est le lieu du labeur où travaillent les érudits, mais aussi ma résidence personnelle et celle de mon clan. Sans aucune concession, je marque chaque pierre, chaque toit, chaque sol, chaque arbre, de mes œuvres, comme conformément au postulat du 09/12/1999.

Cette dualité qui confronte mon engagement de sculpteur plasticien et auteur depuis 25 ans, à ma transversalité de fondateur d’Artprice, du Groupe Serveur et de ses 12 filiales, est à l’origine de critiques parfois violentes d’un patronat conservateur et étriqué mais elle me permet, en échange, par l’atmosphère onirique du lieu, d’accueillir des scientifiques de premier plan et mutants capables d’affronter n’importe quel système économique quelque soit le continent. Le nombre impressionnant de nationalités diverses et variées témoigne de cette nouvelle Babylone du numérique du savoir et de l’information qu’est La Demeure du Chaos.

Les remarques incisives et pertinentes de l’Autorité des Marchés Financiers dans nos désormais célèbres documents de référence pour le marché réglementé, traduisent l’évolution de ma pensée artistique et du passage à l’acte dans le monde économique. Certaines conventions réglementées entre La Demeure du Chaos et les groupes deviennent des prophéties auto-réalisantes où le pouvoir de l’art s’invite dans le monde de la finance. Ma démarche duale enrichit de manière spirituelle La Demeure du Chaos, et de manière matérielle nos 18 000 actionnaires…

Comment peut-on bâtir ex-nihilo Artprice, société mythique qui source 90% de la presse mondiale sur l’information du marché de l’art, sans être soi-même, dans sa chair et son âme, un plasticien passionné d’histoire de l’art ?

La Demeure du Chaos est une redoutable machine de guerre, un cheval de Troie au cœur des marchés financiers. Elle produit et diffuse des sommes de connaissances inimaginables sur le marché de l’art, du droit, de l’économie, de la science pendant que jours et nuits, nous autres plasticiens, intervenons sur les 9 000 m2 pour (ré)écrire avec notre regard d’artiste, l’histoire du monde dé-légendée.

Nos interventions radicales sur la déconstruction de l’habitat professionnel et personnel ainsi que du mobilier a impacté les 2 500 m2 de bureaux où travaillent le Groupe Serveur, ses filiales, et Artprice.

Cette démarche humaniste est partagée entre les artistes et les collaborateurs des deux groupes.

La Demeure du Chaos possède deux visages : celui de l’Alchimie (L’Esprit de la Salamandre) et celui de l’hyper modernité. Mais elle a aussi deux incarnations : celle de l’incarnat physique, avec ses 3 609 œuvres (sculptures, peintures, installations) gravées dans sa chair, avec son double sur Internet où plus de 1 200 000 sites restituent en photos ou en videos tous les regards du monde sur les entrailles de La Demeure du Chaos lors de leurs visites. Sur Google, en novembre 2007, sur les requêtes “Demeure du Chaos” et “Abode of Chaos”, il sort 1 413 000 résultats pointant sur des millions de photos et vidéos de La Demeure du Chaos.

En effet, je suis persuadé que l’Internet est la métaphore du Divin, si ce n’est le Divin lui-même. La voix sèche qui illumine La Demeure du Chaos lui donne le don d’ubiquité entre le monde physique et celui des idées.

Lorsque j’ai démarré Internet en 1987, nous étions moins de 50 000 dans le monde mais j’avais la foi dans la plus grande révolution de toute l’histoire du progrès humain. Internet est mon univers depuis 21 ans où j’ai fondé Net Nobility (cf Time Magazine) pour que demeure toujours, par la volonté des pionniers, cet Internet qui est pour moi, le fils naturel de Proudhon et Bakounine.

Nous sommes en train à La Demeure du Chaos de participer à la reconstruction de la bibliothèque d’Alexandrie de nos pères.

Mémoire du monde selon Philippe Quéau de l’UNESCO, Internet et l’information se joue des frontières, du pouvoir des nations et abolit au passage tous les régimes hostiles à la libre circulation de l’information. Cette dématérialisation de notre ancien monde et de son économie par Internet crée son empire numérique sur le parvis du XXIe siècle sous la forme du grand village glocal (globale

et locale) et chaotique, cher au sociologue Marshall Mc Luhan.

Ainsi, l’éducation, la recherche, le commerce, l’économie et l’organisation générale des informations vont connaître, en un laps de temps extrêmement réduit, des mutations inimaginables. Jamais dans l’histoire de l’humanité, une révolution scientifique n’a impacté autant de gens, en aussi peu de temps, en tout endroit du monde.

Ainsi, plus de 230 états nations qui ont chacun 2 à 3 siècles de cadre législatif et réglementaire

s’annihilent devant une révolution scientifique qui abolit le territoire et le temps. Ce passage du territoire au cyber espace constitue un des grands bouleversements de l’organisation humaine, et il est d’autant plus important d’en comprendre le sens qu’il entraîne une transformation

majeure de la nature même de nos perceptions et de nos rapports sociaux.

Dans l’univers effréné de l’Internet et de la révolution numérique, les entreprises doivent se montrer beaucoup plus protéiformes, capables de changer de profil en un clin d’œil pour s’adapter à de nouvelles conditions économiques draconiennes. La Demeure du Chaos, quartier général du groupe Serveur et d’Artprice, est selon la presse économique anglo-saxonne une forme d’aboutissement ultime d’une économie plus cérébrale, pourrait-on dire, dont l’objet est l’accès au temps et à l’activité de l’esprit.

Tous les jours, par La Demeure du Chaos et ses œuvres, nous entrons dans un tout autre monde, beaucoup plus cérébral et immatériel, un monde de formes platoniciennes, d’idées, d’images et d’archétypes, de concepts et de scénarios. Un monde gouverné par la logique de l’accès au savoir, de l’information et du réseau Internet, ce sont les idées qui deviennent la matière première de l’activité économique, et le but suprême est la connaissance universelle à travers les serveurs d’information.

Governing by Networks

Map of Internet/arpanet sur la Face ouest du Bunker de la Demeure du Chaos

(toile d’acier glycero de 36 m2)

La théorie de l’information prend alors tous son sens.

Être capable d’étendre à l’infini sa présence mentale, être universellement connecté afin de pouvoir affecter et élever peu à peu la connaissance des êtres humains par la distribution du savoir et de l’information organisés (la banque de données), telle est l’ambition humaniste du troisième millénaire.

N’oublions pas que la notion moderne de propriété, caractérisée par la possession privée, l’exclusivité et l’échange marchand, était une des institutions centrales de l’ère industrielle. Au bout de cinq cents ans d’hégémonie, cette vision de la civilisation reposant sur l’échange marchand entre vendeurs et acheteurs de propriété est soumis à une déconstruction radicale qui rejoint le postulat conceptuel que j’ai écrit le 9 décembre 1999 de La Demeure du Chaos.

Le nouvel horizon de l’époque est défini par la logique de l’accès au savoir et à l’information par les serveurs, qui nous amène à repenser les rapports économiques, l’action politique et la perception de notre propre identité telle qu’elle émerge du plus profond de la conscience humaine.

La Demeure du Chaos est une cité médiévale où, dans l’ombre de nos entrailles, nous travaillons à modifier la vision du monde. Un célèbre analyste de Goldman Sachs résume fort bien le tout : “L’Alchimie est présente partout, même dans vos actions en bourse qui ont connu la plus forte croissance, toutes sociétés confondues. Vous avez créé une Alchimie entre votre folie artistique et votre vision de l’industrie du troisième millénaire dans groupe Serveur”. “Avec Artprice et ses 1 300 000 abonnés, vous faites basculer le marché de l’art dans l’hyper modernité en le dématérialisant”.

Quand nos visiteurs économiques repartent ébranlés par cette vision duale de nos groupes dans La Demeure du Chaos, je ne peux m’empêcher de leur dire: vous n’avez encore rien vu ! Ce que nous allons vivre dans les toutes prochaines années dépassera de très loin tous les écrits d’anticipation et de science fiction…

Pour comprendre la dualité de ma démarche de plasticien et de bâtisseur du savoir, je reprendrai la citation de mon vieux maître Pythagore le premier des philosophes pour lequel tout est nombre, à l’exception des essences que sont les émotions humaines non quantifiables, indicibles et se jouant des nombres

thierry Ehrmann (à suivre…)

Poster un Commentaire